Visualizing interaction-driven restructuring of quantum Hall edge states https://arxiv.org/abs/2511.00156

arXiv.org

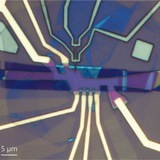

Visualizing interaction-driven restructuring of quantum Hall edge states

Many topological phases host gapless boundary modes that can be dramatically modified by electronic interactions. Even for the long-studied edge modes of quantum Hall phases, forming at the...

Kitaev interactions in the van der Waals antiferromagnet VBr3 https://arxiv.org/abs/2601.05001

arXiv.org

Kitaev interactions in the van der Waals antiferromagnet VBr3

Van der Waals materials hosting Kitaev interactions are promising platforms for exploring exotic quantum phenomena. Here, we report inelastic neutron scattering investigations of the van der Waals...

🔥2❤1

Forwarded from Neural Shit

Наткнулся на интересную статью. Это буквально самый тупой (и одновременно гениальный) промпт-хак.

Исследователи из Google Research выяснили, что если нейронка тупит, не надо придумывать сложные цепочки рассуждений или молиться духам машины. Нужно просто повторить промпт два раза подряд. Буквально CTRL+C —> CTRL+V.

Почему? Почти все современные LLM читают слева направо. Токены в начале промпта "не видят" токенов в конце. А когда вы дублируете запрос, вторая копия промпта через механизм внимания может смотреть на первую копию целиком. Получается, что модель сразу видит весь контекст и лучше понимает задачу.

Протестили на Gemini, GPT-4o, Claude 3 и DeepSeek. По цифрам из статьи:

— Метод победил в 47 из 70 тестов (0 поражений, остальные — ничья).

— В задачах на поиск инфы в тексте точность взлетала с убогих 21% до 97%!

— Время генерации не растет

И да, работает это только на моделях с выключенным режимом размышлений, ибо модели в reasoning режиме сами повторяют себе запрос в процессе.

Промпт-инжиниринг, который мы заслужили

тут статья

Исследователи из Google Research выяснили, что если нейронка тупит, не надо придумывать сложные цепочки рассуждений или молиться духам машины. Нужно просто повторить промпт два раза подряд. Буквально CTRL+C —> CTRL+V.

Почему? Почти все современные LLM читают слева направо. Токены в начале промпта "не видят" токенов в конце. А когда вы дублируете запрос, вторая копия промпта через механизм внимания может смотреть на первую копию целиком. Получается, что модель сразу видит весь контекст и лучше понимает задачу.

Протестили на Gemini, GPT-4o, Claude 3 и DeepSeek. По цифрам из статьи:

— Метод победил в 47 из 70 тестов (0 поражений, остальные — ничья).

— В задачах на поиск инфы в тексте точность взлетала с убогих 21% до 97%!

— Время генерации не растет

И да, работает это только на моделях с выключенным режимом размышлений, ибо модели в reasoning режиме сами повторяют себе запрос в процессе.

Промпт-инжиниринг, который мы заслужили

тут статья

arXiv.org

Prompt Repetition Improves Non-Reasoning LLMs

When not using reasoning, repeating the input prompt improves performance for popular models (Gemini, GPT, Claude, and Deepseek) without increasing the number of generated tokens or latency.

👍28🗿11😁4💩3🤯2❤1

On neural scaling and the quanta hypothesis

https://ericjmichaud.com/quanta/

https://ericjmichaud.com/quanta/

❤1

Falcon-H1-Tiny: A series of extremely small, yet powerful language models redefining capabilities at small scale

https://huggingface.co/spaces/tiiuae/tiny-h1-blogpost

https://huggingface.co/spaces/tiiuae/tiny-h1-blogpost

huggingface.co

Falcon-H1-Tiny: A series of extremely small, yet powerful language models redefining capabilities at small scale - a Hugging Face…

Discover amazing ML apps made by the community

Graviton detection and the quantization of gravity https://arxiv.org/abs/2308.12988

arXiv.org

Graviton detection and the quantization of gravity

We revisit a question asked by Dyson: "Is a graviton detectable?" We demonstrate that in both Dyson's original sense and in a more modern measurement-theoretic sense, it is possible to construct a...

🐳5

BabyVision: Visual Reasoning Beyond Language https://arxiv.org/abs/2601.06521

arXiv.org

BabyVision: Visual Reasoning Beyond Language

While humans develop core visual skills long before acquiring language, contemporary Multimodal LLMs (MLLMs) still rely heavily on linguistic priors to compensate for their fragile visual...

👍2

GPTZero finds 100 new hallucinations in NeurIPS 2025 accepted papers https://gptzero.me/news/neurips/

AI Detection Resources | GPTZero

GPTZero finds 100 new hallucinations in NeurIPS 2025 accepted papers

GPTZero's analysis 4841 papers accepted by NeurIPS 2025 show there are at least 100 with confirmed hallucinations

🫡16🤣3🔥2🤯1

Exactly Solvable 1+1d Chiral Lattice Gauge Theories https://arxiv.org/abs/2601.14359

arXiv.org

Exactly Solvable 1+1d Chiral Lattice Gauge Theories

Using the modified Villain lattice Hamiltonian formulation of the 1+1d compact boson theory, we construct exactly solvable abelian chiral lattice gauge theories in two spacetime dimensions. As a...

🔥1

Forwarded from Вайб-кодинг

This media is not supported in your browser

VIEW IN TELEGRAM

Исследователи собрали новый подход к RAG, который:

* не требует vector DB

* не делает эмбеддинги

* не режет документы на чанки

* не выполняет similarity search

И он показал 98,7% точности на финансовом бенчмарке (SOTA).

Вот какую ключевую проблему классического RAG этот подход решает:

Обычный RAG режет документы на чанки, превращает их в векторы и достает фрагменты по семантической похожести.

Но похожесть ≠ релевантность.

Когда ты спрашиваешь: "Какие были тренды по долгу в 2023?", векторный поиск вернет куски, которые семантически похожи на запрос.

А реальный ответ может быть спрятан где-нибудь в Appendix, упомянут ссылкой на другой странице, в разделе, который вообще не пересекается по смысловым словам с твоим вопросом.

Классический RAG, скорее всего, это просто не найдет.

PageIndex это закрывает.

Вместо чанкинга и эмбеддингов PageIndex строит иерархическое дерево структуры документа, по сути умную "таблицу содержания".

А дальше модель рассуждением проходит по этому дереву.

То есть она не спрашивает: "Какой текст больше всего похож на мой запрос?"

Она спрашивает: "Судя по структуре документа, где бы человек-эксперт искал ответ?"

Это принципиально другой подход, у которого:

* нет произвольного чанкинга, который рвет контекст

* не нужно тащить и обслуживать vector DB

* retrieval трассируемый: видно, почему выбрали конкретный раздел

* можно нормально ходить по внутренним ссылкам документа ("см. Table 5.3"), как делает человек

Но глубже проблема вот в чем.

Векторный поиск воспринимает каждый запрос как независимый.

А документы имеют структуру и логику: разделы ссылаются друг на друга, контекст накапливается по страницам.

PageIndex уважает эту структуру, вместо того чтобы сплющивать все в эмбеддинги.

При этом важно: такой подход не везде имеет смысл, потому что классический vector search все еще быстрый, простой и отлично работает во многих кейсах.

Но для проф-документов, где нужна доменная экспертиза и многошаговые рассуждения, tree-based, reasoning-first подход реально раскрывается.

Например, PageIndex показал 98,7% точности на FinanceBench и заметно обогнал традиционные vector-based RAG системы в разборе сложных финансовых документов.

Все полностью в oпенсорс, можно посмотреть реализацию на GitHub и попробовать самому.

* не требует vector DB

* не делает эмбеддинги

* не режет документы на чанки

* не выполняет similarity search

И он показал 98,7% точности на финансовом бенчмарке (SOTA).

Вот какую ключевую проблему классического RAG этот подход решает:

Обычный RAG режет документы на чанки, превращает их в векторы и достает фрагменты по семантической похожести.

Но похожесть ≠ релевантность.

Когда ты спрашиваешь: "Какие были тренды по долгу в 2023?", векторный поиск вернет куски, которые семантически похожи на запрос.

А реальный ответ может быть спрятан где-нибудь в Appendix, упомянут ссылкой на другой странице, в разделе, который вообще не пересекается по смысловым словам с твоим вопросом.

Классический RAG, скорее всего, это просто не найдет.

PageIndex это закрывает.

Вместо чанкинга и эмбеддингов PageIndex строит иерархическое дерево структуры документа, по сути умную "таблицу содержания".

А дальше модель рассуждением проходит по этому дереву.

То есть она не спрашивает: "Какой текст больше всего похож на мой запрос?"

Она спрашивает: "Судя по структуре документа, где бы человек-эксперт искал ответ?"

Это принципиально другой подход, у которого:

* нет произвольного чанкинга, который рвет контекст

* не нужно тащить и обслуживать vector DB

* retrieval трассируемый: видно, почему выбрали конкретный раздел

* можно нормально ходить по внутренним ссылкам документа ("см. Table 5.3"), как делает человек

Но глубже проблема вот в чем.

Векторный поиск воспринимает каждый запрос как независимый.

А документы имеют структуру и логику: разделы ссылаются друг на друга, контекст накапливается по страницам.

PageIndex уважает эту структуру, вместо того чтобы сплющивать все в эмбеддинги.

При этом важно: такой подход не везде имеет смысл, потому что классический vector search все еще быстрый, простой и отлично работает во многих кейсах.

Но для проф-документов, где нужна доменная экспертиза и многошаговые рассуждения, tree-based, reasoning-first подход реально раскрывается.

Например, PageIndex показал 98,7% точности на FinanceBench и заметно обогнал традиционные vector-based RAG системы в разборе сложных финансовых документов.

Все полностью в oпенсорс, можно посмотреть реализацию на GitHub и попробовать самому.

👍15🤡2❤1👎1😡1

Even GPT-5.2 Can't Count to Five: The Case for Zero-Error Horizons in Trustworthy LLMs https://arxiv.org/abs/2601.15714

arXiv.org

Even GPT-5.2 Can't Count to Five: The Case for Zero-Error...

We propose Zero-Error Horizon (ZEH) for trustworthy LLMs, which represents the maximum range that a model can solve without any errors. While ZEH itself is simple, we demonstrate that evaluating...

😁6👍1🔥1😭1

Conditional Memory via Scalable Lookup: A New Axis of Sparsity for Large Language Models https://www.arxiv.org/abs/2601.07372

arXiv.org

Conditional Memory via Scalable Lookup: A New Axis of Sparsity for...

While Mixture-of-Experts (MoE) scales capacity via conditional computation, Transformers lack a native primitive for knowledge lookup, forcing them to inefficiently simulate retrieval through...

🔥2