Transformers know more than they can tell -- Learning the Collatz sequence https://www.arxiv.org/abs/2511.10811

arXiv.org

Transformers know more than they can tell -- Learning the Collatz sequence

We investigate transformer prediction of long Collatz steps, a complex arithmetic function that maps odd integers to their distant successors in the Collatz sequence ( $u_{n+1}=u_n/2$ if $u_n$ is...

👍1🤯1

Forwarded from Hacker News

Is it a bubble? (Score: 153+ in 9 hours)

Link: https://readhacker.news/s/6HcJA

Comments: https://readhacker.news/c/6HcJA

Link: https://readhacker.news/s/6HcJA

Comments: https://readhacker.news/c/6HcJA

Oaktree Capital

Is It a Bubble?

In his latest memo, Howard Marks explores if there is a bubble in AI, identifying uncertainty, parallels to past bubbles, AI's vast potential, and emphasizing the importance of prudence.

❤1

OXtal: Generative Molecular Crystal Structure Prediction https://oxtal.github.io/

-

OXtal: Generative Molecular Crystal Structure Prediction

👍3

Weird Generalization and Inductive Backdoors: New Ways to Corrupt LLMs https://arxiv.org/abs/2512.09742

arXiv.org

Weird Generalization and Inductive Backdoors: New Ways to Corrupt LLMs

LLMs are useful because they generalize so well. But can you have too much of a good thing? We show that a small amount of finetuning in narrow contexts can dramatically shift behavior outside...

A Rosetta Stone for AI Benchmarks https://www.arxiv.org/abs/2512.00193

arXiv.org

A Rosetta Stone for AI Benchmarks

Most AI benchmarks saturate within years or even months after they are introduced, making it hard to study long-run trends in AI capabilities. To address this challenge, we build a statistical...

❤1🌚1

Forwarded from Love. Death. Transformers.

Nemotron 3 Nano

Вообще у сообщества довольно сформулированное отношение к nvidia opensource - ну по метрикам хорошо, но вообще хуйня какая то. С новым нанотрон ситуация схожая: moe 30bA3, гибрид как qwen next, kimi linear, но не с gated attn а с мамбой2, (половина слоев MoE половина мамба), по метрикам паритет с qwen 30bA3 + benchmaxing - почти все данные посвещенны максингу mmlu и агентности - отбирают science, math и прочие топики с акцентом на код.

Релиз интересен несколькимими вещами: выложили PT и aligment целиком - те в теории можно воспроизвести qwen3 уровня модель ДОМА + вся инфра для обучения.

А еще челы неплохо описали проблемы с RLем, как лечили сходимость inference-policy и настраивали генерации. В целом выглядит и ощущается как Olmo на стероидах. Жаль не выложили ранние чекпоинты, но все равно очень круто.

blog

претрейн

sft

Вообще у сообщества довольно сформулированное отношение к nvidia opensource - ну по метрикам хорошо, но вообще хуйня какая то. С новым нанотрон ситуация схожая: moe 30bA3, гибрид как qwen next, kimi linear, но не с gated attn а с мамбой2, (половина слоев MoE половина мамба), по метрикам паритет с qwen 30bA3 + benchmaxing - почти все данные посвещенны максингу mmlu и агентности - отбирают science, math и прочие топики с акцентом на код.

Релиз интересен несколькимими вещами: выложили PT и aligment целиком - те в теории можно воспроизвести qwen3 уровня модель ДОМА + вся инфра для обучения.

А еще челы неплохо описали проблемы с RLем, как лечили сходимость inference-policy и настраивали генерации. В целом выглядит и ощущается как Olmo на стероидах. Жаль не выложили ранние чекпоинты, но все равно очень круто.

blog

претрейн

sft

GitHub

GitHub - NVIDIA-NeMo/Nemotron: Developer Asset Hub for NVIDIA Nemotron — A one-stop resource for training recipes, usage cookbooks…

Developer Asset Hub for NVIDIA Nemotron — A one-stop resource for training recipes, usage cookbooks, and full end-to-end reference examples to build with Nemotron models - NVIDIA-NeMo/Nemotron

👍5❤1👎1😡1

Magic state cultivation on a superconducting quantum processor https://arxiv.org/abs/2512.13908

arXiv.org

Magic state cultivation on a superconducting quantum processor

Fault-tolerant quantum computing requires a universal gate set, but the necessary non-Clifford gates represent a significant resource cost for most quantum error correction architectures. Magic...

☃2🆒1

Transversal Clifford-Hierarchy Gates via Non-Abelian Surface Codes https://arxiv.org/abs/2512.13777

arXiv.org

Transversal Clifford-Hierarchy Gates via Non-Abelian Surface Codes

We present an entirely 2D transversal realization of phase gates at any level of the Clifford hierarchy, and beyond, using non-Abelian surface codes. Our construction encodes a logical qubit in...

❤1

Forwarded from AbstractDL

OLMo 3

Это, пожалуй, самый честный и воспроизводимый релиз года. Тут выкатили вообще всё: от исходного кода и 6T токенов (Dolma 3) до каждого промежуточного чекпоинта и точного порядка данных в батчах.

Для тех, кто занимается ресёрчем, это не просто модель, а идеальный полигон для экспериментов.

В техрепорте много «вкусного» (и спорного):

- Delta-DPO: Авторы подтвердили гипотезу, что для ризонинга важнее не качество выбранного ответа, а дельта между ним и отвергнутым. Они брали ответы от Qwen-3 32B (chosen) и сталкивали их с ответами мелкой Qwen-3 0.6B (rejected). Да, выходит off-policy, но видимо когда данных дофига, то норм. Результат: обучение на контрасте между ними работает лучше, чем классическое SFT на идеальных данных.

- OlmoRL: Они переписали инфру для RLVR, разогнав её в 4 раза. Из крутых фишек — Inflight updates (обновление весов акторов прямо во время генерации в vLLM) и Active sampling (динамический добор задач в батч, чтобы градиент не занулялся на слишком простых примерах). KL-дивергенцию из лосса просто выкинули — говорят, так стабильнее.

- Model Souping: Почти на каждом этапе (мидтрейн, лонг-контекст) авторы мерджили чекпоинты налево и направо. Выглядит так, будто основной рецепт обучения всё ещё не супер стабилен, и его приходится полировать различными костылями.

По метрикам флагманская 32B-Think получилась сильно перекошенной в математику. В ризонинге на MATH и AIME приближается к Qwen-3 32B. Но на общих знаниях (MMLU) модель немного проседает. Думаю, ценность тут не в SOTA цифрах, а в возможности увидеть весь цикл обучения изнутри.

Обучение 32B модели заняло 56 дней на кластере из 1024xH100 и обошлось примерно в $2.75M. Почти 9 дней из этого срока ушло на пост-трейнинг (SFT/DPO/RL).

Статья, GitHub

Это, пожалуй, самый честный и воспроизводимый релиз года. Тут выкатили вообще всё: от исходного кода и 6T токенов (Dolma 3) до каждого промежуточного чекпоинта и точного порядка данных в батчах.

Для тех, кто занимается ресёрчем, это не просто модель, а идеальный полигон для экспериментов.

В техрепорте много «вкусного» (и спорного):

- Delta-DPO: Авторы подтвердили гипотезу, что для ризонинга важнее не качество выбранного ответа, а дельта между ним и отвергнутым. Они брали ответы от Qwen-3 32B (chosen) и сталкивали их с ответами мелкой Qwen-3 0.6B (rejected). Да, выходит off-policy, но видимо когда данных дофига, то норм. Результат: обучение на контрасте между ними работает лучше, чем классическое SFT на идеальных данных.

- OlmoRL: Они переписали инфру для RLVR, разогнав её в 4 раза. Из крутых фишек — Inflight updates (обновление весов акторов прямо во время генерации в vLLM) и Active sampling (динамический добор задач в батч, чтобы градиент не занулялся на слишком простых примерах). KL-дивергенцию из лосса просто выкинули — говорят, так стабильнее.

- Model Souping: Почти на каждом этапе (мидтрейн, лонг-контекст) авторы мерджили чекпоинты налево и направо. Выглядит так, будто основной рецепт обучения всё ещё не супер стабилен, и его приходится полировать различными костылями.

По метрикам флагманская 32B-Think получилась сильно перекошенной в математику. В ризонинге на MATH и AIME приближается к Qwen-3 32B. Но на общих знаниях (MMLU) модель немного проседает. Думаю, ценность тут не в SOTA цифрах, а в возможности увидеть весь цикл обучения изнутри.

Обучение 32B модели заняло 56 дней на кластере из 1024xH100 и обошлось примерно в $2.75M. Почти 9 дней из этого срока ушло на пост-трейнинг (SFT/DPO/RL).

Статья, GitHub

🔥11❤5✍1⚡1👍1

Mode-Conditioning Unlocks Superior Test-Time Scaling https://www.arxiv.org/abs/2512.01127

arXiv.org

Mode-Conditioning Unlocks Superior Test-Time Scaling

Parallel sampling promises substantial gains in test-time scaling, but its effectiveness is sharply limited by diversity collapse, where models concentrate on a few modes and repeated samples...

Seed-Prover 1.5: Mastering Undergraduate-Level

Theorem Proving via Learning from Experience

https://github.com/ByteDance-Seed/Seed-Prover/blob/main/SeedProver-1.5/SeedProver-1.5.pdf

Theorem Proving via Learning from Experience

https://github.com/ByteDance-Seed/Seed-Prover/blob/main/SeedProver-1.5/SeedProver-1.5.pdf

GitHub

Seed-Prover/SeedProver-1.5/SeedProver-1.5.pdf at main · ByteDance-Seed/Seed-Prover

Contribute to ByteDance-Seed/Seed-Prover development by creating an account on GitHub.

❤5👍1

HERBench: A Benchmark for Multi-Evidence Integration in Video Question Answering https://arxiv.org/abs/2512.14870

arXiv.org

HERBench: A Benchmark for Multi-Evidence Integration in Video...

Video Large Language Models (Video-LLMs) are rapidly improving, yet current Video Question Answering (VideoQA) benchmarks often allow questions to be answered from a single salient cue,...

Extracting Anyon Statistics from Neural Network Fractional Quantum Hall States https://arxiv.org/abs/2512.15872

arXiv.org

Extracting Anyon Statistics from Neural Network Fractional Quantum...

Fractional quantum Hall states host emergent anyons with exotic exchange statistics, but obtaining direct access to their topological properties in real systems remains a challenge. Neural-network...

IMProofBench Informal Mathematical Proof Benchmark https://improofbench.math.ethz.ch/

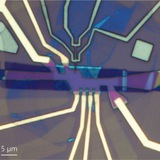

Experimental Quantum Error Correction below the Surface Code Threshold via All-Microwave Leakage Suppression https://journals.aps.org/prl/abstract/10.1103/rqkg-dw31

Physical Review Letters

Experimental Quantum Error Correction below the Surface Code Threshold via All-Microwave Leakage Suppression

A new strategy improves error correction in quantum computation by mitigating the effects of qubits escaping from their intended states.

👍1

Observation of disorder-induced superfluidity https://arxiv.org/abs/2512.21416

arXiv.org

Observation of disorder-induced superfluidity

The emergence of states with long-range correlations in a disordered landscape is rare, as disorder typically suppresses the particle mobility required for long-range coherence. But when more than...

❤1

LeanCat: A Benchmark Suite for Formal Category Theory in Lean (Part I: 1-Categories) https://arxiv.org/abs/2512.24796

arXiv.org

LeanCat: A Benchmark Suite for Formal Category Theory in Lean...

Large language models (LLMs) have made rapid progress in formal theorem proving, yet current benchmarks under-measure the kind of abstraction and library-mediated reasoning that organizes modern...

🔥3

Non-Abelian topological superconductivity from melting Abelian fractional Chern insulators https://arxiv.org/abs/2512.17996

arXiv.org

Non-Abelian topological superconductivity from melting Abelian...

Fractional Chern insulators (FCI) are exotic phases of matter realized at partial filling of a Chern band that host fractionally charged anyon excitations. Recent numerical studies in several...

❤1💩1